Virtuelle Realität zur Bereitstellung integrierter Suchumgebungen

Zusammenfassung:

Das Exzellenzcluster Kognitive Interaktionstechnologie (CITEC) an der Universität Bielefeld beschäftigt sich seit 2013 mit der virtuellen Realität (VR). Ausgehend von konkreten Projektkooperationen (Publikations- und Forschungsdatenmanagement) mit der Universitätsbibliothek ist die Idee entstanden, mit der in 2016 neu angebotenen Konsumer-VR-Hardware die im Labor entwickelten Interaktionstechniken auf geeignete Szenarien im Bereich von bibliothekarischen Umgebungen anzuwenden. Als interessantes Anwendungsgebiet kristallisierte sich im gemeinsamen Diskurs die Literatursuche heraus: Als Suchsystem wurde die Bielefelder BASE-Datenbank (d.i. Bielefeld Academic Search Engine mit inzwischen mehr als 100 Mio. indexierten Dokumenten) ausgewählt. Diese Auswahl erfolgte vor dem Hintergrund, dass sich die von zahlreichen externen Institutionen bereits genutzte API-Schnittstelle als universell und robust erwiesen hat und umfangreiche Funktionen bereitstellt. Auf der Grundlage der umfangreichen theoretischen und praktischen Erfahrungen des CITEC mit VR-Techniken wurde der Prototyp für eine virtuelle Suchumgebung realisiert, der ein Retrieval in einem Suchraum von Online-Dokumenten erlaubt. Die Nutzerinnen und Nutzer können die Suchanfrage explorativ zusammenstellen und dabei die Ergebnisse intuitiv verwalten. Unterstützt werden sie dabei durch Ergebnisanzeige, Sortierung, Optimierung des Suchergebnisses mittels Suchverfeinerung (Drilldown-basiert) oder Anfrageerweiterung und Wiederverwendung von abgelegten Ergebnissen. Gleichzeitig wird der Zugriff- und Lizenzstatus visualisiert und die Detailanzeige der Metadaten des Objektes integriert.

Summary:

CITEC (Cluster of Excellence Cognitive Interaction Technology) at Bielefeld University has been engaged in virtual reality (VR) since 2013. Based on concrete joint project activities (publication and research data management) together with Bielefeld University Library the idea emerged to use consumer-VR hardware to transfer laboratory interaction techniques to library environments. In our co-operation, discussions have focused on literature search. The partners decided to choose BASE (Bielefeld Academic Search Engine, indexing more than 100 million documents) not least because the BASE API is used by more than 200 external institutions, has proven to be robust, and offers a broad range of functionality. Based on the broad theoretical and practical experience of CITEC with VR technology, a prototype for a virtual search environment has been developed, supporting a search space of online documents. Users may construct a query in an explorative way and manage the results intuitively. This includes result display as well as optimizing the search results by means of search refinement (based on drilldown facets), search query adoption and re-use of contents. Besides that, the access and re-use status is visualized and the display of document metadata has been integrated.

1. Die Partner

1.1. Universitätsbibliothek

Die Universitätsbibliothek Bielefeld kann auf eine lange Vorgeschichte im Bereich innovativer bibliothekarischer Suchumgebungen verweisen. Auf eine frühe OPAC-Version (Nur-Lese-Zugriff auf das Katalogisierungssystem 1979) folgte die erste CD-ROM-OPAC-Version in Deutschland als DFG-gefördertes Vorhaben 1988 und kurz darauf als Weiterentwicklung eine Kataloganwendung im lokalen Netzwerk. Spätere Entwicklungen umfassten einen selbst produzierten Web-OPAC (1996), die Metasuche im Rahmen der Digibib NRW 1999, die Suchmaschine BASE 2004 und eine integrierte Suchumgebung mit einer Kombination aus dem Nachweis von lokal lizenzierten Publikationen, Discovery Service und Web-Dokumenten (via BASE) seit 2013.1 Besonderes Kennzeichen war es immer, innovative aber zugleich auch pragmatische Lösungen zu entwickeln und diese dann nachfolgend in die bibliothekarische Praxis zu überführen.

Ein Aktivposten im Projektumfeld der Universitätsbibliothek ist die über einen längeren Zeitraum entstandene Netzwerkinfrastruktur, die sowohl lokale als auch Drittmittel-geförderte Projekte beinhaltet und dabei oftmals in Kooperation mit Partnern erfolgt. Das schließt sowohl andere wissenschaftliche Einrichtungen der Universität als auch externe Institutionen mit ein. Beispiele für lokale Kooperationen sind dabei Projekte wie der sogenannte Intelligente Rechercheassistent (mit der Technischen Fakultät), ein automatischer Klassifikator (mit dem Arbeitsbereich Computerlinguistik der Fakultät für Linguistik und Literaturwissenschaft) und das laufende CONQUAIRE-Projekt2 im Themenfeld Forschungsdatenmanagement mit dem CITEC (siehe unten). Diese Ansätze waren bzw. sind allesamt Drittmittel-gefördert. Dabei haben insbesondere die verstärkten Aktivitäten in wissenschaftsnahen Services der letzten Jahre in den Bereichen Publikationsmanagement, Publikationsdienste, Forschungsdatenmanagement und die Bereitstellung von Tools im Kontext der Informationsversorgung zu Kontakten und Kooperationen mit wissenschaftlichen Einrichtungen wie CITEC, Genomforschung, Sonderforschungsbereichen und einzelnen Fakultäten geführt. Letztlich haben diese Ansätze auch den Weg für das hier vorgestellte Kooperationsprojekt geebnet.

1.2. CITEC

Das Exzellenzcluster Kognitive Interaktionstechnologie (CITEC) wurde 2007 in Bielefeld gegründet, seit 2013 ist es in einem neuen Gebäude untergebracht. Am CITEC arbeiten zurzeit 250 Wissenschaftlerinnen und Wissenschaftler aus 5 Fakultäten (Biologie, Linguistik und Literaturwissenschaft, Mathematik, Psychologie und Sportwissenschaft, Technik/Informatik).

Die Themen, die im CITEC erforscht werden, sind: Bewegungsintelligenz, Systeme mit Aufmerksamkeit, Situierte Kommunikation sowie Gedächtnis und Lernen. Das CITEC unterhält verschiedene Labore, darunter auch das Virtual Reality Lab (VR Lab), vertreten durch Dr. Thies Pfeiffer, das in diesem Fall als Ansprechpartner fungierte.

2. Das Lösungskonzept aus Sicht der Universitätsbibliothek

Bei einem ersten Treffen mit Direktion, Benutzung und Technik der Universitätsbibliothek Anfang November 2016 wurden vom VR Lab drei mögliche Szenarien und Lösungsansätze für einen Einsatz von Methoden der Virtuellen und Erweiterten Realität in der Bibliothek vorgestellt und zur Auswahl angeboten. Dabei handelte es sich – basierend auf entsprechenden CITEC-Vorarbeiten – um die Optionen:

• Virtuelle Suchumgebung

• Digitaler Arbeitsplatz

• Navigationsumgebung

Nachdem die Entscheidung für den Punkt „Virtuelle Suchumgebung“ gefallen war, wurde eine feste Arbeitsgruppe gebildet, bestehend aus drei Mitarbeitenden der Universitätsbibliothek und einem Studenten aus dem CITEC, der die technischen Grundlagen im Rahmen seiner Bachelorarbeit schaffen sollte. Wöchentliche Treffen bis in den Januar 2017 mit intensiven Diskussionen zu den Detailvorgaben und der Festlegung einer Lösungskonzeption wurden abgelöst durch Abstimmungen in zeitlich größerem Abstand, durch die auf Basis der herausgearbeiteten Grundlagen für den Prototyp eine vorzeigbare Fassung entwickelt wurde.

Wesentliches Thema der ersten Besprechungen waren die Details der BASE-Schnittstelle und ihrer Nutzung. Obwohl – bedingt durch die intensive Verwendung von ca. 200 Projektpartnern – im Hinblick auf die Stabilität, Belastbarkeit und auch Dokumentation ein hohes Maß an Qualität erreicht worden ist, war die spezielle Expertise der Schnittstellenentwickler von Vorteil.3 Dabei spielten diese Kriterien auch eine entscheidende Rolle bei der zunächst diskutierten Frage, welcher der drei möglichen Schnittstellenoptionen (Bibliothekskatalog, Publikationsmanagement oder BASE) der Vorzug gegeben werden sollte. Die Entscheidung für BASE begründet sich in erster Linie auf der Annahme, dass ein Suchraum mit direkt verfügbaren Web-Dokumenten für eine VR-basierte Umgebung am ehesten geeignet ist.4 Gegen eine Umsetzung des Bibliothekskatalogs sprach u.a. die komplexe Datenstruktur des Katalogs mit Haupt- und Unteraufnahmen, z.B. Zeitschriftentiteln und den dazu gehörigen Bänden.

Nach Betrachtung der BASE-Schnittstelle schloss sich eine Diskussion der Kernfunktionalität an, bei der man auch zunächst ein Basisverständnis für die VR-Technik und ihre Möglichkeiten entwickeln musste. Aus der langjährigen Erfahrung mit der Entwicklung von Web-Schnittstellen für bibliografische Suchumgebungen wurden Vorstellungen entwickelt, die nutzerkonforme Metaphern für vertraute Funktionalitäten und Abläufe herausarbeiten sollten. Neben der Festlegung der Kernfunktionalitäten zur Umsetzung des Such-Arbeitsplatzes beinhaltet dieses Vorgehen die Festlegung der Gestaltung der Umgebung. Hierbei war es das Ziel, eine Verbindung einer angenehmen Arbeitsatmosphäre mit einer gewohnten Bibliotheksumgebung zu schaffen. Danach wurden die Anschlussfunktionalitäten betrachtet und dabei deren Manifestation und die Verknüpfung der Abläufe definiert. Das betraf insbesondere die Punkte Ergebnisanzeige, Drilldown zur Suchverfeinerung, Export, Termübernahme in die Suchquery und die Detailanzeige. Auch hier stand die Umsetzung in Form der visuellen Gestaltung der Situation und ihrer Übergänge im Mittelpunkt. So wurde die Buchsymbolik für einzelne Ergebnisobjekte hergeleitet und das Bücherregal als Ablageobjekt gewählt.

3. Das Lösungskonzept aus CITEC-Sicht

Es gibt Menschen, die in beeindruckender Weise große Zahlen abrufen können. Sie schaffen es beispielsweise, die Reihenfolge von 52 Karten in 22 Sekunden oder 1000 Zahlen in 30 Minuten zu speichern. Diese außerordentliche Fähigkeit des symbolischen Gedächtnisses kann nur durch Verwendung spezieller Techniken erreicht werden.5 Die „Method of Loci“ (MOL) ist eine davon, wobei alle Symbole einer Sequenz mit Orten eines bestimmten Weges assoziiert werden.6 Durch die Verbindung von Symbolen mit visuellen und räumlichen Strukturen können zusätzliche Bereiche des Gedächtnisses aktiviert und verwendet werden. Eine Technik, die von MOL abgeleitet wurde, ist in den vergangenen Jahren durch die BBC-Serie „Sherlock“ sehr bekannt geworden, weil der Protagonist Sherlock Holmes intensiven Gebrauch von dieser Technik macht. Das menschliche Gehirn kann also mit multi-modal zugänglichen Daten deutlich besser umgehen als mit Daten, für die es nur einen einseitigen Zugang gibt.

Ein zweites Beispiel: Um auf digitale Information zuzugreifen, sind Adressen notwendig, die in Form einer URL oder als Dateipfad auf einer Festplatte kodiert werden. Gefragt, „für wie viele digitale Objekte können Sie eine exakte Adresse nennen, so dass man diese Information ohne eine Suche finden kann“, zögern die Teilnehmenden der Vorlesungen von Dr. Pfeiffer typischerweise: Die meisten trauen sich weniger als 50 zu, wenige mehr als 100. Werden sie allerdings gefragt, „Stellen Sie sich vor, Sie haben etwas zuhause vergessen und Sie müssen jemanden instruieren, um es für Sie zu holen. Für wie viele Objekte wären Sie in der Lage, eine geeignete Beschreibung der Position in Ihrer Wohnung zu liefern?“, sind die Zuhörer typischerweise überzeugt, die Positionen von 1000 und mehr Objekten nennen zu können. Und das gilt nur für die Objekte zuhause. Eine Mischung aus Defaults (Messer liegen typischerweise in der Küche oder im Esszimmer) und räumlichen Informationen ermöglicht dies.

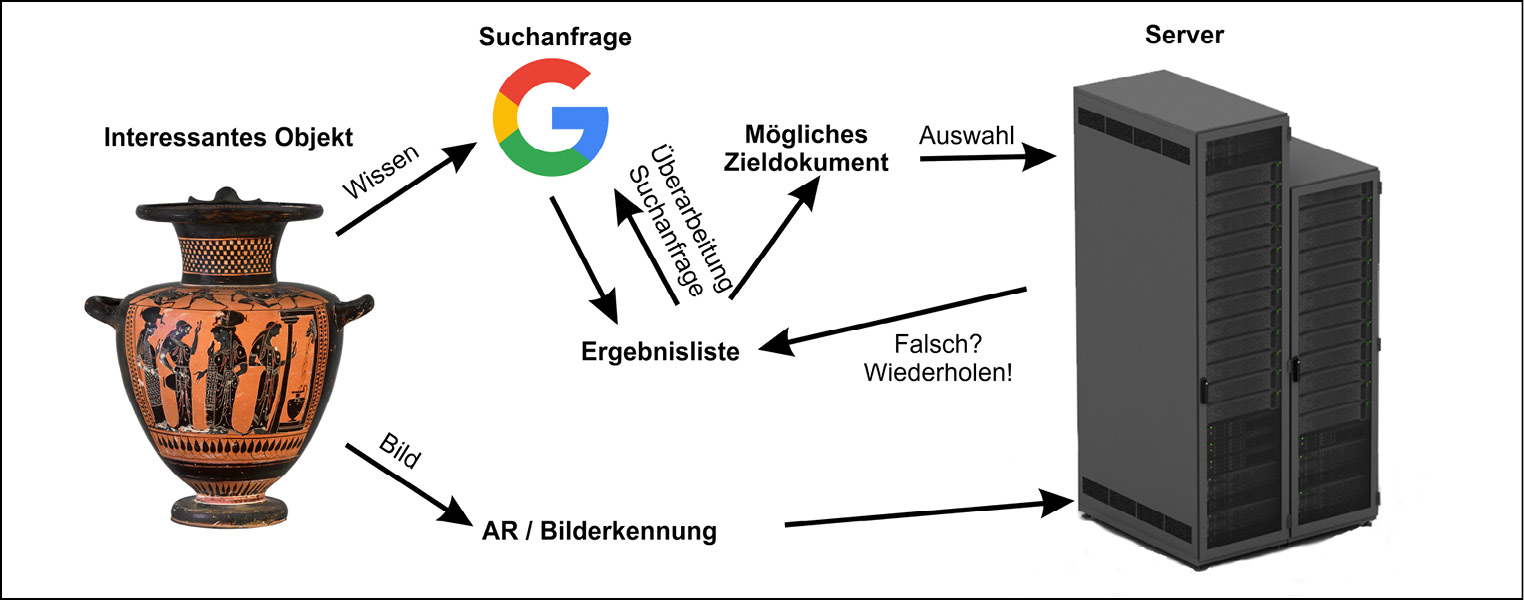

Wenn wir eine URL nicht direkt wissen, müssen wir derzeit eine Suchmaschine verwenden, um die korrekte zu finden. Allerdings müssen wir dafür in der Lage sein, eine semantische Beschreibung der Information zu liefern, die wir suchen. Abb. 1 zeigt ein Beispiel, bei dem die Information über eine bestimme antike Vase gewünscht wird. Um diese Information zu finden, muss man relevante Suchterme nennen können, mit denen eine Suchmaschine beschickt werden kann. Die Ergebnisliste wird die gesuchte Vase enthalten oder nicht. Im zweiten Fall muss die Suchanfrage iterativ verfeinert oder die Trefferliste durchgesehen werden. Letztendlich mag die URL zur gewünschten Information gefunden werden. Das Beispiel zeigt, wie heute eine multi-modale Erfahrung wie eine Vase in eine abstrakte symbolische Beschreibung verwandelt werden muss, um zur digitalen Information zu gelangen. Dieser Prozess erfordert hohe kognitive Fähigkeiten und erworbenes Wissen. Wenn man Methoden der Augmented Reality (AR) verwendet, kann die Vase durch visuelle Computermethoden erkannt werden und man wird direkt zur gewünschten Information geführt.

Menschen leben primär in einer dreidimensionalen, multimodalen Welt. Heute allerdings werden große Teile unserer Umgebung digital repräsentiert. Es gibt nur kleine Fenster (Smartphones, Tablets, Computer) mit sehr limitierten Benutzerschnittstellen (Maus, Touchoberflächen, Tastaturen), die es uns erlauben, an dieser Welt teilzuhaben. Virtuelle Realität (VR) und Augmented Reality sind dabei, das zu verändern. Die Augmented Reality hat das Potenzial, digitale Information und Realwelt-Objekte zusammenzuführen. Digitale Information kann hierüber mit einer Oberfläche und Form, und damit mit Rauminformationen, versehen werden und über Hilfsmittel mit manuellen Methoden sogar verändert werden. Virtuelle Realität geht noch weiter. Sie erlaubt es, Räume zu erschaffen und zu erkunden in einer Weise, wie es in der Realität nicht möglich wäre. Einen Gedankenpalast zu erschaffen, der nur auf unserem Gehirn aufbaut, erfordert Training und kontinuierlichen Aufwand. Virtuelle Realität erlaubt es uns, endlose Gedankenpaläste zu erschaffen – sogar in Zusammenarbeit mit anderen.

4. Die Rolle der VR- und AR-Technologie

Kürzlich konnte gezeigt werden, dass die immersive Erfahrung (das Gefühl, als wäre man dort) virtueller Umgebungen das Lernen verbessern kann.7 Insbesondere die in den virtuellen Umgebungen konstruierte räumliche Information kann durch menschliche Teilnehmer/innen genutzt werden, um die Gedächtnisleistung zu verbessern.8 Die ichbezogene Perspektive, die den menschlichen Beobachter in die Rolle des Akteurs versetzt, hat dabei einen positiven Effekt auf die Gedächtnisleistung.9 Aktuellen Entwicklungen in der Immersions-Technologie, wie hochauflösenden Brillen-Displays, konnten signifikante Performance-Verbesserungen bezogen auf die erreichte Erinnerungsleistung in Verbindung zu ihrer höheren Stufe an Immersion nachgewiesen werden.10

4.1. Eine Exkursion von der Realität zur Virtualität

Im November 2016 wurde eine Gruppe der Universitätsbibliothek Bielefeld von Herrn Dr. Pfeiffer eingeladen, um im CITEC Virtual Reality Lab eine Vorführung verschiedener Forschungsprototypen aus dem Bereich Virtueller Realität, Mixed und Augmented Reality zu erleben.

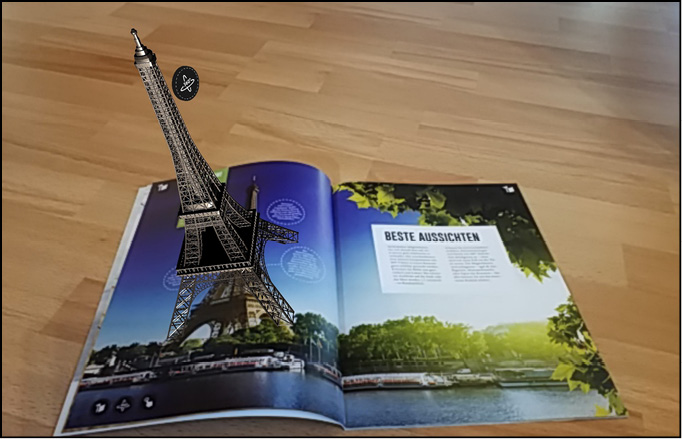

Typische Beispiele für Augmented Reality nutzen ein reales Objekt wie beispielsweise eine Seite eines Schulbuches als Grundlage, um interaktive 3D-Grafikobjekte darüber zu projizieren (wie beim Eiffelturm in Abb. 2). Die Forschungsprototypen am CITEC erweitern diese Ansätze, indem sie Wissen erzeugen und es in reale Aufgaben einbinden, um Augmented-Reality-Hilfssysteme zu schaffen.11 Der Nutzer kann mit diesen Erweiterungen experimentieren. Dabei können sowohl handelsübliche Smartphones und Tablets, aber auch spezielle Geräte, wie die Augmented-Reality-Brille Microsoft Hololens genutzt werden.

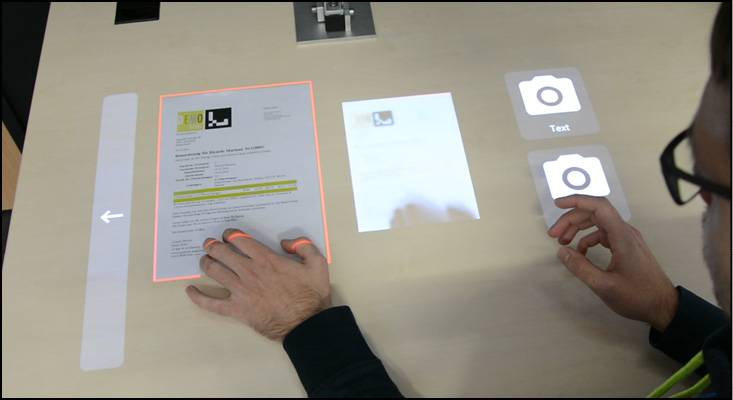

Mixed-Reality-Systeme versuchen, die Interaktion von physischen und virtuellen Objekten einander näher zu bringen, wie es in Abb. 3 am Beispiel eines Dokumentenmanagementsystems gezeigt wird: Hier kann der Nutzer bedruckte Papiere auf die Oberfläche eines Tisches legen, ein Kamera-System erkennt diese Vorlagen, ermittelt verbundene digitale Objekte aus einer Datenbank und stellt diese auf derselben Tischoberfläche mittels eines Projektors dar.12 Diese Verbindung von Technologien lassen reale und digitale Objekte im gleichen Raum nebeneinander koexistieren. Mit Hilfe von manuellen Aktionen wie „Drag and Drop“ lassen sich beide Arten von Objekten manipulieren.

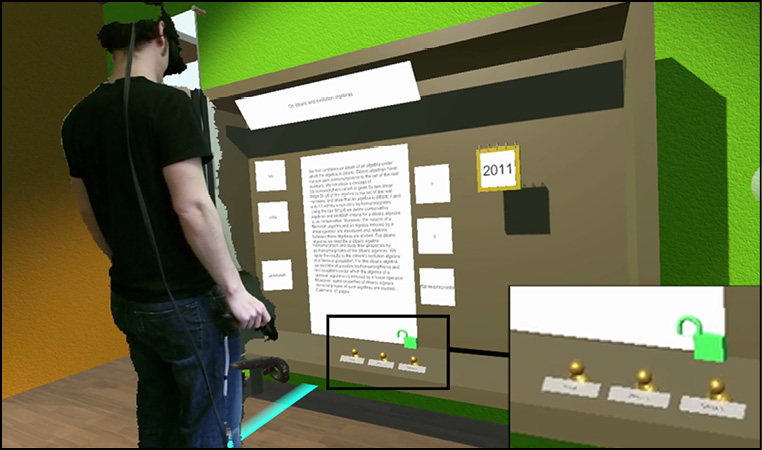

Ein Virtual-Reality-Interface besetzt das andere Ende des Virtualitäts-Kontinuums, wie es von Milgram u.a. 13 definiert wird: In diesem Fall ist der Nutzer ohne jegliche physikalische Einschränkung völlig eingebunden in eine digital erzeugte Welt. In einem der Industrieprojekte am CITEC wurde ein virtueller Büroarbeitsplatz für ein Dokumentmanagementsystem geschaffen, das ein virtuelles Interface für einen Dokumentserver bereitstellt.

Während der Diskussion im VR-Lab entstand schnell die Idee, dass der Prozess der Literatursuche ein interessantes Feld für ein immersives Virtual-Reality-Interface darstellt. Ab diesem Zeitpunkt gab es regelmäßige Arbeitstreffen, um dieses Vorhaben weiterzuentwickeln und die Idee auszuarbeiten.

4.2. Die drei Prozesse der Literaturrecherche

In den Gesprächen zwischen Bibliothek und CITEC wurden die folgenden drei Hauptprozesse der Literaturrecherche identifiziert:

a) Erzeugung der Suchanfrage und Ermittlung der Ergebnisliste.

b) Sichtung der Ergebnisliste mit dem potenziellen Detail Einzelsatzanzeige und Auswahl von einzelnen Objekten für eine persönliche Bibliografie.

c) Sichtung der Ergebnisliste, Nutzung der Facetten zur Strukturierung der Ergebnisse in Verbindung mit den verschiedenen Kategorien (z.B. Jahr und Erscheinungsort, Verfasser, Schlagworte, etc.), Auswahl bestimmter Facetten-Spezifika und Aktualisierung als Folge des ausgewählten Drilldowns.

4.3. Die Technologie

Für die Realisierung des immersiven Suchinterfaces wurde eine HTC Vive Head Mounted Display (HMD) verwendet (s. Abb. 5). Das System bietet einen interaktiven, stereoskopischen Blick auf die Umgebung in Verbindung mit einem raumfassenden Tracking- System, das Bereiche im Ausmaß von 25m2 erfasst. Zwei Controller mit mehreren Knöpfen und einem Trackpad erlauben eine manuelle Interaktion mit vielen Freiheitsgraden. Alternativ kann das System mit einer Leap Motion verbunden werden, die dem HMD zugeordnet werden kann, um mit einem optischen Tracking die Bewegung der Benutzerfinger zu erfassen. Das Programm für das Interface wurde dabei mit der Spiele-Engine Unity3D implementiert. Der Computer, auf dem diese Software eingesetzt wurde, verwendete eine 4 GHz Intel CPU und eine NVidia GTX 1080.

4.4. Räumlichkeit schaffen: Funktionale Räume

Der erste Schritt zur Transformation des web-basierten 2D-Interfaces der Suchmaschine BASE in ein immersives Interface bestand darin, ein räumliches Umfeld zu produzieren. In realen Arbeitsumgebungen wie Handwerksbetrieben oder häuslichen Wohnumgebungen ist der verfügbare Raum aufgeteilt in funktional unterschiedliche Bereiche. Es gibt spezifische Handlungen, die man in der Küche vornimmt und andere, für die das Wohnzimmer verwendet wird. Mit diesem Hintergrund wurde das räumliche Design der immersiven Literatursuche auf Basis der funktionalen Räume implementiert (s. Abb. 6). Dieses Vorgehen soll es dem Nutzer erlauben, spezifische Objekte und Prozesse mit unterschiedlichen Orten zu verbinden, abzuspeichern und auf diese Weise den Lernprozess unterstützen. Es hat sich herausgestellt, dass dies auch das Gesprächsverhalten über die Interaktion in der Umgebung unterstützt, da Aktionen mit Orten verbunden und referenziert werden können.

4.5. Symbolen eine Form geben

Ein wichtiger Aspekt der realen Welt ist es, dass jedes Objekt eine bestimmte Form, Farbe(n) und Oberflächenstruktur aufweist. Das macht jedes Objekt individuell und erlaubt uns eine Erkennung und eine Unterscheidung zwischen unterschiedlichen Objekten, selbst aus größeren Entfernungen. Mit einer reinen textuellen Repräsentation ist das deutlich schwieriger bzw. teilweise unmöglich: In Fällen größerer Entfernungen können einzelne Buchstaben nicht ausreichend erkannt werden und Wortgrenzen verschwimmen. Ein räumliches Interface, bei dem sämtliche Informationseinheiten durch Text repräsentiert werden, führt daher zu einem visuellen Durcheinander. Auf diese Weise wird der nutzbare Raum letztlich künstlich auf den lesbaren Bereich verkürzt.

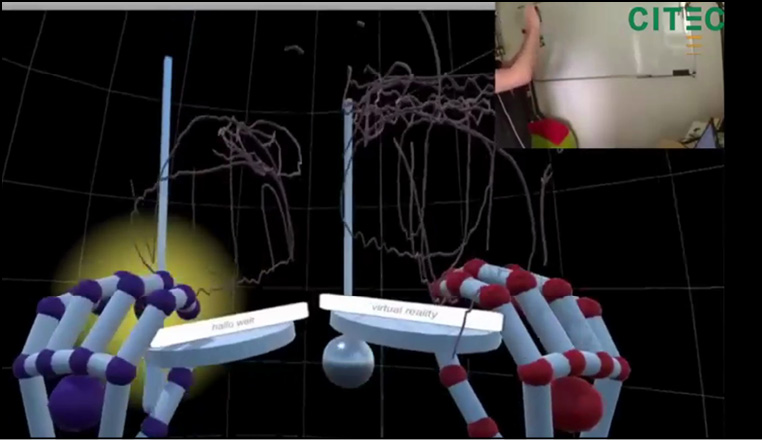

Stattdessen wurde ein anderer Ansatz implementiert, der es dem Nutzer erlaubt, ergänzend zum Text eine individuelle Form für jedes Symbol on-the-fly zu erzeugen. Das wurde wie folgt realisiert: Für die Texteingabe wird eine virtuelle Tastatur bereitgestellt, die durch die Nutzerhände gesteuert wird (s. Abb. 7). Um die Texteingabe zu starten, hat der Nutzer mit Daumen und Zeigefinger zu greifen (Pinzettengriff). Während der Texteingabe beschreibt die Handbewegung eine bestimmte Verlaufskurve über der Tastatur (ähnlich wie die Wischbewegungen, die auf einem Smartphone visualisiert werden). Dieser Verlauf wird automatisch abgespeichert, als deutliche Linie visualisiert. Wenn die Greifbewegung gelöst wird, wird die Texteingabe als beendet interpretiert. In diesem Moment wird die Verlaufskurve vom ersten Zeitpunkt der Texteingabe bis zum Abschluss in eine Skulptur verwandelt, die ab sofort die individuelle Form zur Repräsentation des eingegebenen Textes darstellt. Wenn nur die Bewegungskurve auf der Tastaturoberfläche verwendet würde, sähen die auf diese Weise erstellten Strukturen ziemlich individuell, aber uninspiriert aus. Daher wurde eine weitere Ergänzung vorgenommen: Der Bewegungsablauf aller Handbewegungen während der Greifbewegung wird gespeichert. Auf diese Weise kann der Nutzer die Anfrage Buchstabe für Buchstabe eingeben, aber dann die Tastatur verlassen und eine Form schaffen, z.B. eine Silhouette oder Zusammenfassung eines Objekts als Beschreibung, was dann zusammen mit der Bewegung über die Tastatur als Form des Terms dienen kann. Diese Technik erlaubt es dem Nutzer, kreativ individuelle Formen zu schaffen, die, zumindest für ihn, den Term ab diesem Zeitpunkt repräsentieren. Wir nennen diesen Ansatz die ad-hoc-shapification von Symbolen (s. Abb. 7 für zwei Beispiele).

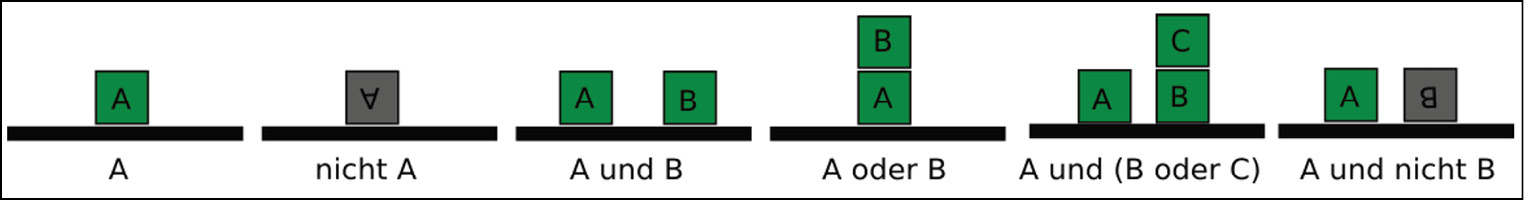

4.6. Explorative Suchanfrageerstellung

Ein zentraler Funktionsbereich ist die Werkbank, an der die Suchanfrage konstruiert werden kann (Abb. 8). Das geschieht in einem konstruktiven Prozess, bei dem die einzelnen Terme der Suche in expressiver Weise auf dem Tisch mit einer realitätsnahen Simulation zusammengestellt werden. Daher können die Komponenten des Suchstrings in ähnlicher Weise wie Holzbausteine verwendet werden. Sie können nahe beieinander platziert werden, was als Konjunktion interpretiert wird. Sie können auf den Kopf gedreht werden, um sie zu negieren. Sie können aufeinandergestapelt werden, um eine Disjunktion auszudrücken. Die Menge der verfügbaren Operationen ist in Abb. 9 dargestellt.

Wenn die Konstruktion der Suchanfrage abgeschlossen ist, kann der Nutzer einen Knopf drücken, über den die Ergebnisse ermittelt und als Bücher in einem virtuellen Bücherregal visualisiert werden (s. Abb. 10). Der Prozess kann jederzeit ausgelöst werden, so dass der Nutzer kreativ in der Komposition seiner Query sein kann. Durch den Blick auf das visualisierte Bücherregal bekommt der Nutzer sofort ein Feedback, welche Effekte die neue Komposition auf die Ergebnisliste hat. Den Arbeitsplatz muss er dabei nicht verlassen.

4.7. Drilldown und Detailanzeige

Rechts neben dem Regal mit den Ergebnissen steht ein Schrank mit einer interaktiven Vorrichtung (s. Abb. 11), die es dem Nutzer ermöglicht, eine bestimmte Facette der Ergebnisse auszuwählen und relevante Unterergebnisse der Facette zu identifizieren, um damit die Ergebnisliste zu verfeinern. Jede Änderung, die an dieser Vorrichtung erfolgt, führt sofort zu einer Aktualisierung der Ergebnisanzeige im Bücherregal. Wenn der Nutzer an den Details eines bestimmten Buchs oder Dokuments interessiert ist, kann er es aus dem Regal nehmen und es in einen besonderen Schrank stellen, der eine Detailanzeige des Inhalts und der Metadaten des Dokuments liefert (s. Abb. 12).

Dieses Vorgehen führt uns zu einem abschließenden Konzept, das mit diesem Demonstrator realisiert wurde: Spezifische atomare Informationen werden wie physikalische Objekte repräsentiert und können dann auch wie solche manipuliert werden. In der Detailanzeige werden zum Beispiel die Autoren eines Dokuments wie kleine Figuren mit Namensschildern dargestellt (unterer Teil von Abb. 12). Da diese Repräsentationen Objekte der physikalischen Simulation sind, kann der Nutzer sie aufnehmen und sie zum Beispiel auf der Werkbank platzieren. Durch diese Aktion wird die Originalanfrage mit einem Selektor für einen bestimmten Autor erweitert. Abhängig davon, wie die Autorenfigur platziert wird, beispielsweise auf den Kopf gestellt, wird die Anfrage entsprechend modifiziert. Die Realisierung der Informationspakete als „physikalische Objekte“ und der kompositorische Ansatz der Anfrage-Werkbank lädt den Nutzer ein, die Suchumgebung zu erforschen und mit den Möglichkeiten zu spielen. Der Nutzer kann mögliche Aktionen aus dem ableiten, was physikalisch in der Realität möglich ist. Die Aktualisierung der Ergebnisliste nach der Neukomposition der Anfrage ist für ihn jedoch neuartig. Hier müssen noch passende Interaktionskonzepte im Detail ausgearbeitet werden.

5. Diskussion und Ausblick

Bisher wurde die Arbeit mit digitaler Information charakterisiert von Schnittstellen mit einer Dominanz von symbolischen Operationen (d.h. Texteingabe), einem linearen 2D-Layout und sehr abstrakten Aktionen (Texteingabe, 2D-Mausbewegungen). Die menschlichen Fähigkeiten sind weitgehend ungenutzt geblieben. Über Virtuelle Realität realisierte immersive Interfaces befreien Nutzerschnittstellen von diesen Einschränkungen. Der Beispielfall zeigt, wie funktionale Räume und in Formen gebrachte Symbole verwendet werden können, um Information mit Raum zu verbinden. Dadurch, dass Bestandteile der Information als Objekte geformt werden, wird den Nutzerinnen und Nutzern ein reichhaltiges konstruktives Interface bereitgestellt, mit dem sie frei experimentieren und neue Anfragen zu ihrer Wissensbasis zusammenstellen können, in diesem Fall eine Suchmaschine für wissenschaftliche Literatur. Die Nutzerschnittstelle versetzt den Menschen in die Rolle eines Akteurs, dem sie ein spielerisches Experimentieren und Erforschen des Informationsraumes erlaubt. Gleichzeitig können die Nutzerinnen und Nutzer die gesamte Information strukturieren, in dem sie eindeutige Arrangements von Objekten im Raum anlegen. Sie sind, so könnte man sagen, Bürger/innen erster Klasse im digitalen Informationsraum geworden.

Aus Sicht der Universitätsbibliothek kann ein durchweg positives Fazit für die Initiative gezogen werden. Die Zusammenarbeit mit einer Forschungseinrichtung der Universität hat zwei unterschiedliche Sichtweisen zu einem konstruktiven Ergebnis zusammengebracht, das die Expertise beider Seiten berücksichtigt. Damit hat sich der kooperative Ansatz mit einer wissenschaftlichen Forschungseinrichtung durchaus bewährt. Das Ziel, einen innovativen, visionären Prototyp einer VR-Suchumgebung zu schaffen, ist definitiv erreicht worden. Der Diskurs hat die Bibliothekssicht mit dem Ansatz, die Möglichkeiten der neuen Technik in ihrem Kontext auszuloten, erfüllt und in der Konsequenz die Möglichkeit eröffnet, entsprechende Konzepte intern zu diskutieren, zu erproben und auch zu modifizieren. Die intensiven Diskussionen haben dabei auch potenzielle, VR-adäquate Erweiterungen herauskristallisiert wie z.B. eine Visualisierung der Quellenherkunft in Form einer Globusdarstellung oder den Einsatz von Text-Mining-Methoden zur Herausarbeitung der wesentlichen Themenwörter (Wordclouds) aus dem Dokumenttext, um sie zur kondensierten Inhaltsbeschreibung und nachfolgend auch zur Übernahme als Suchterm bereitzustellen. In jedem Fall ist deutlich geworden, dass mit dem Ergebnis der gemeinsamen Initiative eine solide Basis für ein Drittmittel-gefördertes Nachfolgeprojekt erarbeitet worden ist.

6. Danksagung

Diese Forschung wurde zum Teil durch den Exzellenzcluster Kognitive Interaktionstechnologie ‚CITEC‘ (EXC 277) an der Universität Bielefeld unterstützt, der durch die Deutsche Forschungsgemeinschaft gefördert wird.

Literaturverzeichnis

– Bäcker, Amelie, Christian Pietsch, Friedrich Summann und Sebastian Wolf. „BASE (Bielefeld Academic Search Engine): Eine Suchmaschinenlösung zur Indexierung wissenschaftlicher Metadaten.“ Datenbank-Spektrum 17, Nr. 1 (2017): 5–13. http://doi.org/10.1007/s13222-017-0246-9.

– Blattgerste, Jonas, Benjamin Strenge, Patrick Renner, Thies Pfeiffer und Kai Essig. „Comparing Conventional and Augmented Reality Instructions for Manual Assembly Tasks.“ In PETRA ‘17: Proceedings of the 10th International Conference on Pervasive Technologies Related to Assistive Environments. Rhodes, Greece, 2017. http://doi.org/10.1145/3056540.3056547.

– Bowman, Douglas A., Ajith Sowndararajan, Eric D. Ragan und Regis Kopper. „Higher levels of immersion improve procedure memorization performance.“ In Proceedings of the EGVE-ICAT-EuroVR, 2009. https://doi.org/10.2312/EGVE/JVRC09/121-128.

– Dede, Chris. „Immersive Interfaces for Engagement and Learning.“ Science 323, Nr. 5910 (2. Januar 2009): 66–69. https://doi.org/10.1126/science.1167311.

– Jund, Thomas, Antonio Capobianco und Frédéric Larue. „Impact of Frame of Reference on Memorization in Virtual Environments.” In 2016 IEEE 16th International Conference on Advanced Learning Technologies (ICALT), 533–537, 2016. https://doi.org/10.1109/ICALT.2016.77.

– Legge, Eric L. G., Christopher R. Madan, Enoch T. Ng und Jeremy B. Caplan. „Building a memory palace in minutes: Equivalent memory performance using virtual versus conventional environments with the Method of Loci.“ Acta Psychologica 141, Nr. 3 (November 2012): 380–390. https://doi.org/10.1016/j.actpsy.2012.09.002.

– Madan, Christopher R. „Augmented Memory: A Survey of the Approaches to Remembering More.“ Frontiers in Systems Neuroscience 8 (2014). https://dx.doi.org/10.3389%2Ffnsys.2014.00030.

– Milgram, Paul, Haruo Takemura, Akira Utsumi und Fumio Kishino. „Augmented reality: A class of displays on the reality-virtuality continuum.“ In Photonics for industrial applications, 282–292. International Society for Optics and Photonics, 1995. http://dx.doi.org/10.1117/12.197321.

– Neumann, Henri, Patrick Renner und Thies Pfeiffer. „Entwicklung und Evaluation eines Kinect v2-basierten Low-Cost Aufprojektionssystems.“ In Virtuelle und Erweiterte Realität – 12. Workshop der GI-Fachgruppe VR/AR, herausgegeben von André Hinkenjann, Jens Maiero, und Roland Blach, 22–33. Bonn: Shaker Verlag, 2015.

– Pieper, Dirk und Friedrich Summann. „10 Years of ‚Bielefeld Academic Search Engine‘ (BASE): Looking at the Past and Future of the World Wide Repository Landscape from a Service Providers Perspective.“ Vortrag auf der 10th International Conference on Open Repositories in Indianapolis vom 8.–11. Juni 2015. Vortragsfolien unter: http://nbn-resolving.de/urn:nbn:de:0070-pub-27663089.

– Ragan, Eric D., Doug A. Bowman und Karl J. Huber. „Supporting Cognitive Processing with Spatial Information Presentations in Virtual Environments.“ Virtual Reality 16, Nr. 4 (1. November 2012): 301–314. https://doi.org/10.1007/s10055-012-0211-8.

– Summann, Friedrich, Christian Pietsch und Dirk Pieper. „Die Cloud im lokalen Bibliothekskatalog: eine integrative lokale Portallösung mit nahtlos eingebundenem Discovery Service der Universitätsbibliothek Bielefeld.“ Vortrag auf dem 105. Deutschen Bibliothekartag in Leipzig am 13. März 2013. Vortragsfolien unter: http://nbn-resolving.de/urn/resolver.pl?urn:nbn:de:0290-opus-14686.

1 Friedrich Summann, Christian Pietsch und Dirk Pieper, „Die Cloud im lokalen Bibliothekskatalog: eine integrative lokale Portallösung mit nahtlos eingebundenem Discovery Service der Universitätsbibliothek Bielefeld“ (Vortrag auf dem 105. Deutschen Bibliothekartag in Leipzig am 13. März 2013), Vortragsfolien unter: http://nbn-resolving.de/urn/resolver.pl?urn:nbn:de:0290-opus-14686.

2 „About CONQUAIRE,“ zuletzt geprüft am 23.10.2017, http://conquaire.uni-bielefeld.de/about/.

3 Dirk Pieper und Friedrich Summann, „10 Years of ‚Bielefeld Academic Search Engine‘ (BASE): Looking at the Past and Future of the World Wide Repository Landscape from a Service Providers Perspective“ (Vortrag auf der 10th International Conference on Open Repositories in Indianapolis vom 8.-11. Juni 2015), Vortragsfolien unter: http://nbn-resolving.de/urn:nbn:de:0070-pub-27663089.

4 Amelie Bäcker u. a., „BASE (Bielefeld Academic Search Engine): Eine Suchmaschinenlösung zur Indexierung wissenschaftlicher Metadaten,“ Datenbank-Spektrum 17, Nr. 1 (2017): 5–13, http://doi.org/10.1007/s13222-017-0246-9.

5 Christopher R. Madan, „Augmented Memory: A Survey of the Approaches to Remembering More,“ Frontiers in Systems Neuroscience 8 (2014), https://dx.doi.org/10.3389%2Ffnsys.2014.00030.

6 Eric L. G. Legge u. a., „Building a memory palace in minutes: Equivalent memory performance using virtual versus conventional environments with the Method of Loci,“ Acta Psychologica 141, Nr. 3 (November 2012): 380–390. https://doi.org/10.1016/j.actpsy.2012.09.002.

7 Chris Dede, „Immersive Interfaces for Engagement and Learning,“ Science 323, Nr. 5910 (2. Januar 2009): 66–69, https://doi.org/10.1126/science.1167311.

8 Eric D. Ragan, Doug A. Bowman und Karl J. Huber, „Supporting Cognitive Processing with Spatial Information Presentations in Virtual Environments,“ Virtual Reality 16, Nr. 4 (1. November 2012): 301–314, https://doi.org/10.1007/s10055-012-0211-8.

9 Thomas Jund, Antonio Capobianco und Frédéric Larue, „Impact of Frame of Reference on Memorization in Virtual Environments,“ in 2016 IEEE 16th International Conference on Advanced Learning Technologies (ICALT), 2016, 533–537, https://doi.org/10.1109/ICALT.2016.77.

10 Douglas A. Bowman u. a., „Higher levels of immersion improve procedure memorization performance,“ in Proceedings of the EGVE-ICAT-EuroVR, 2009, https://doi.org/10.2312/EGVE/JVRC09/121-128.

11 Jonas Blattgerste u. a., „Comparing Conventional and Augmented Reality Instructions for Manual Assembly Tasks,“ in PETRA ‘17: Proceedings of the 10th International Conference on Pervasive Technologies Related to Assistive Environments (Rhodes, Greece, 2017), http://doi.org/10.1145/3056540.3056547.

12 Henri Neumann, Patrick Renner und Thies Pfeiffer, „Entwicklung und Evaluation eines Kinect v2-basierten Low-Cost Aufprojektionssystems,“ in Virtuelle und Erweiterte Realität - 12. Workshop der GI-Fachgruppe VR/AR, hrsg. André Hinkenjann, Jens Maiero und Roland Blach (Bonn: Shaker Verlag, 2015), 22–33.

13 Paul Milgram u. a., „Augmented reality: A class of displays on the reality-virtuality continuum,“ in Photonics for industrial applications (International Society for Optics and Photonics, 1995), 282–292, http://dx.doi.org/10.1117/12.197321.