Kompetenzorientierte Evaluation des adaptiven Schulungskonzepts TUBLIK der Universitätsbibliothek Heidelberg

Zusammenfassung:

Im Vergleich zu den Bibliotheken angloamerikanischer Länder verwenden deutsche Bibliotheken bisher kaum sozialwissenschaftliche Evaluationsmethoden, um den Nutzen von Veranstaltungskonzepten für die Steigerung von Informationskompetenz nachzuweisen und die Vermittlungsmethoden zu verbessern. Ansatzpunkte zur Beseitigung dieser Defizite bietet das an der Universitätsbibliothek Heidelberg durchgeführte Projekt TUBLIK (Tutoren- und Blended-Learning-basierte Vermittlung von Informationskompetenz), bei dem mehrere sozialwissenschaftliche Verfahren eingesetzt wurden. Mit den angewandten Methoden konnten eine Steigerung der Informationskompetenz bei Studierenden durch TUBLIK nachgewiesen und Vorschläge zur methodischen Optimierung des Konzepts erarbeitet werden. Deutlich wurde auch, dass eine systematische Weiterentwicklung von Evaluationsmethoden zur Messung von Informationskompetenz und der Aufbau von sozialwissenschaftlichen Methodenkompetenzen an Bibliotheken erforderlich sind.

Summary:

Compared to libraries in Anglo-American countries, sociological evaluation methods are only rarely used by German libraries in order to measure the impact of training concepts on information literacy and to improve the teaching methods. The project TUBLIK (Tutoren- und Blended-Learning-basierte Vermittlung von Informationskompetenz) at the University Library of Heidelberg, which makes use of several social science methods, offers a starting point for addressing these deficiencies. With the methods applied, it was shown that students’ information literacy competencies have increased due to TUBLIK and it was possible to develop methodological proposals for optimizing the concept. It also became evident that it is necessary to systematically develop evaluation methods for measuring information literacy and to build up expertise in social science methods at libraries.

1. Einleitung

Schulungen zur Vermittlung von Informationskompetenz sind inzwischen ein wichtiges Aufgabenfeld der deutschen Bibliotheken. Das methodische Spektrum des Angebots reicht dabei von einfachen Vorträgen bis hin zu eigenständigen curricular verankerten Veranstaltungen. Hinzu kommen verstärkt internetbasierte Angebote, die zunehmend anspruchsvoller werden, wie die Beiträge beim Best-Practice-Wettbewerb der IK-Kommission in diesem Jahr zeigen.1

Diese Entwicklung ist erfreulich, denn sie verdeutlicht, dass die didaktisch-methodischen Qualifikationen der Bibliothekare verbessert und ihre Kompetenzen beträchtlich erweitert wurden. Die Erstellung von Konzepten und deren Umsetzung reicht jedoch nicht aus, um insbesondere im Hochschulbereich eine systematische Durchdringung der Studienfächer bzw. die Integration der Angebote in die einzelnen Fächer zu realisieren. Gerade im Kontext der Hochschulen werden wissenschaftlich fundierte Studien erwartet, in denen der Nutzen eines Konzepts nachgewiesen wird. Für die von der Hochschulrektorenkonferenz geforderte Aufnahme in die Curricula der Studienfächer ist es deshalb wichtig, dass bei neuen Vermittlungskonzepten auch deren Nutzen bzw. Wirkung nachgewiesen wird.2

Evaluationsmethoden, die primär auf Veranstaltungsbeurteilungen der Teilnehmenden basieren, sind hierfür nicht ausreichend. Erforderlich sind Methoden, die es ermöglichen, anhand nachvollziehbarer Evaluationskriterien das Vorhandensein und die Ausprägung von Informationskompetenz zu messen und Veränderungen, die aus der Teilnahme an einer Schulungsveranstaltung resultieren, zu diagnostizieren.

Diese Anforderungen wurden im Projekt TUBLIK (Tutoren- und Blended-Learning-basierte Vermittlung von Informationskompetenz) berücksichtigt, indem der konkrete Nutzen bzw. die Steigerung der individuellen Informationskompetenz anhand sozialwissenschaftlicher Methoden überprüft wurden. Eingesetzt wurden dabei mehrere Methoden: kompetenzorientiertes Assessment, outcome-basierter Kompetenzvergleich und konzeptbezogene Evaluation. Die Methoden und die dabei erzielten Ergebnisse werden den Schwerpunkt der folgenden Ausführungen bilden. Ergänzend wird im ersten Kapitel ein Überblick über den aktuellen Stand der Evaluation von Informationskompetenz gegeben.

2. Zum Stand der Evaluation von Informationskompetenz

Die deutschen Bibliotheken beschränkten sich bei der Bewertung ihrer Aktivitäten im Bereich der Vermittlung von Informationskompetenz bisher weitgehend auf Nutzerbefragungen. Dabei werden die Veranstaltungsteilnehmer/innen nach ihrer subjektiven Meinung zu den Inhalten, den eingesetzten Methoden, ihrem Lernerfolg und perspektivischen Nutzen gefragt. Hilfreich sind solche Befragungen, um Hinweise für eine Weiterentwicklung bzw. Verbesserung von Schulungskonzepten zu erhalten. Eine objektive Messung von Lernerfolgen oder bereits vorhandenen Kompetenzen ist auf diesem Weg nicht möglich.

Orientierungspunkte für die Entwicklung von Evaluationsverfahren im Bibliotheksbereich bieten die anglo-amerikanischen Länder. Erste Aktivitäten zur systematischen Evaluation von Informationskompetenz und Vermittlungskonzepten sind in den USA schon in den 1970er Jahren zu finden. So wurden bereits 1971 outcome-bezogene Evaluationsmethoden in Form von Analysen von Hausarbeiten eingesetzt, um die Eignung von alternativen Methoden bei der Vermittlung von Recherchestrategien zu überprüfen.3 In den folgenden Jahrzehnten nutzten viele amerikanische Bibliotheken fast das gesamte Spektrum sozialwissenschaftlicher Methoden bei der Evaluation von Schulungskonzepten: Analysen von Bibliographien, qualitative Analyse von Aufsätzen, Multiple Choice, Teilnehmerbefragung, Teilnehmerbeobachtung, Analyse von Lernportfolios, Quiz, Selbstbeurteilung, Simulationen etc.4 Ein wichtiger Meilenstein bei diesen Evaluationsaktivitäten bildet dabei der „Information Literacy Test“ (ILT)5, der auf den amerikanischen „Information Literacy Competency Standards for Higher Education“6 basiert und als Online-Test eine relativ effiziente Analyse ermöglicht.

In Deutschland sind erste Ansätze zur systematischen Entwicklung von Evaluationsverfahren erst in den letzten Jahren zu konstatieren. Hervorzuheben sind dabei besonders die Dissertation von Michael Balceris und die Arbeiten am „Zentrum für Psychologische Information und Dokumentation“ (ZPID) in Trier.

Basierend auf seinem Modell HIKS (Handlungsmodell Informationskompetenz von Schülern) entwickelte Balceris einen Test mit umfangreichen Fragen zur Erfassung der Informationskompetenz bei Schülerinnen und Schülern7. Er knüpft dabei an die Entwicklungen in den angloamerikanischen Ländern an und befasst sich ausführlich mit den deutschen Aktivitäten in den Bereichen Informations- und Medienkompetenz sowie Kompetenzforschung. Diese fundierte Studie bietet wichtige Ansatzpunkte für weitere methodische Entwicklungen von Evaluationsverfahren im Bereich der Informationskompetenz.

Von zentraler Bedeutung für die Evaluation von Informationskompetenz sind die Arbeiten des ZPID.8 Im Rahmen des „BLink“-Projekts wurden neben der Entwicklung von Schulungskonzepten für Studierende der Psychologie9 Evaluationsmethoden zur Messung von Informationskompetenz erstellt und getestet. Von grundlegender Bedeutung ist dabei das neue kompetenzorientierte Verfahren PIKE,10 das ergänzend zu traditionellen deklarativen Testverfahren entwickelt wurde. Hierbei werden situationsbezogene Handlungsalternativen genutzt, um die Kompetenz von Personen zu messen. Ausgehend von realitätsbezogenen Situationen werden den Proband/inn/en im Test mehrere passende Handlungsalternativen zur Auswahl gestellt. Ein entscheidendes Merkmal der PIKE-Methode ist, dass die Messung nicht auf Richtig-/Falschbewertungen von vorgegebenen Antworten, sondern auf Präferenzrelationen zwischen vorgegebenen Handlungsalternativen basiert: Eine Testperson beurteilt die Handlungsalternativen nach dem Grad ihrer Eignung für die Lösung eines Problems. Die Präferenzrelationen der getesteten Personen werden dann mit Präferenzrelationen von Expert/inn/en verglichen, die im Rahmen einer speziellen Expertenbefragung entwickelt wurden. Die Präferenzrelationen der Expert/inn/en bilden dabei den Auswertungsschlüssel. Dieses Verfahren wurde erfolgreich als Assessmentinstrument am ZPID genutzt und für die kompetenzorientierte Evaluation im Projekt TUBLIK in modifizierter Form übernommen.

3. Projekt und Konzept TUBLIK

Die Universitätsbibliothek Heidelberg befasst sich seit über 20 Jahren mit der Vermittlung von Informationskompetenz und bietet neben Präsenzveranstaltungen auch umfangreiche Materialien zum Selbststudium an. In einigen Fächern werden auch curricular verankerte Wahlpflichtveranstaltungen durchgeführt, in denen Informationskompetenz umfassend, in Orientierung an den Standards der Informationskompetenz, vermittelt wird. Die curricularen Veranstaltungen sind teilweise als Blended-Learning-Veranstaltung unter Nutzung der E-Learning-Plattform Moodle konzipiert. Auf dieser Erfahrungsgrundlage basiert das Projekt TUBLIK und die Entwicklung des gleichnamigen Vermittlungskonzepts, das in den Jahren 2014 und 2015 realisiert wurde.

Vor dem Hintergrund der Forderungen der Hochschulrektorenkonferenz nach einer umfassenden curricularen Verankerung von Informationskompetenz an Hochschulen und der beschränkten personellen Ressourcen der Bibliotheken wurde mit dem Konzept die Realisierung folgender Ziele angestrebt:

• Einbeziehung von Tutor/inn/en oder Dozent/inn/en als Multiplikator/inn/en, die auf diese Weise ein besseres Verständnis von Informationskompetenz aus fachlicher Perspektive entwickeln und dementsprechend besser vermitteln können.

• Einsatz von E-Learning für die Bereitstellung von Lehr-/Lernmaterialien, wodurch sich neue Möglichkeiten des Selbststudiums und der Nachnutzung bzw. der Übernahme in andere Veranstaltungen eröffnen.

• Flexible Anpassbarkeit der Lehr-/Lernangebote an die spezifischen Anforderungen und die organisatorischen Bedingungen der Studienfächer.

Ein weiteres wichtiges Ziel des Projekts war die systematische Evaluation. Konkret sollte überprüft werden, ob bei Studierenden die Informationskompetenz durch die Teilnahme an den Lehrveranstaltungen gesteigert wird und ob das Konzept Rationalisierungspotenziale bei der Nutzung in unterschiedlichen Kontexten bietet.

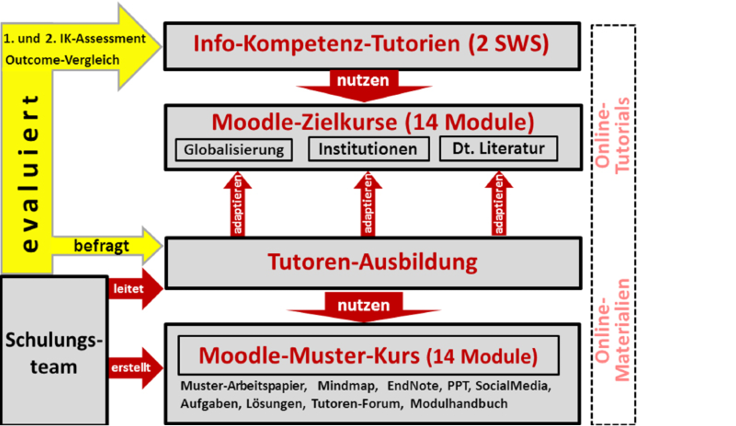

Die Komponenten des TUBLIK-Konzepts und die Ansatzpunkte für die Evaluation sind aus der nachfolgenden Abbildung zu ersehen.

Grundlage des Konzepts ist der vom Schulungsteam erstellte Musterkurs auf der E-Learning-Plattform Moodle. Der Kurs untergliedert sich in 14 Module, die die Struktur für eine eigenständige curriculare Veranstaltung mit 2 Semesterwochenstunden bilden. Die Module enthalten Grundlagentexte, PPT-Folien, Aufgaben, Lösungsvorschläge, Kommunikationsforen und weitere Materialien sowie ein Modulhandbuch mit Inhaltsbeschreibungen, Lernzielen, Literaturhinweisen und Ablaufplanungen. Online-Materialien der Universitätsbibliothek sind als Links in das Konzept eingebunden. Ein Drittel der Module wurde als reine Online-Module konzipiert, z.B. die Erarbeitung neuer Datenbanken oder Fragen des Urheberrechts.

Ein weiteres zentrales Element bildet die Tutorenausbildung. Tutor/inn/en oder auch Dozent/inn/-en lernen in mehreren Workshops das Konzept mit der Modulstruktur, den Lernmaterialien und Aufgaben sowie die Handhabung von Moodle als Teacher kennen. Im Rahmen des TUBLIK-Projekts beteiligten sich sieben Tutor/inn/en aus den Fächern Bildungswissenschaft und Deutsch als Fremdsprache vor Beginn des WS 2014/15 an den über eine Woche angebotenen Workshops.

Die Tutor/inn/en erstellen danach Moodle-Zielkurse, die sie an die Anforderungen ihres Faches und nach Möglichkeit auch an die Inhalte einer thematischen Lehrveranstaltung anpassen. Im WS 2014/15 wurden drei Zielkurse für Tutorien erstellt und eingesetzt: im Studienfach Bildungswissenschaft bei Veranstaltungen zu den Themen „Globales Lernen und Weltgesellschaft“ und „Institutionen der pädagogischen Praxis“; im Studienfach „Deutsch als Fremdsprache“ bei der Veranstaltung „Deutsche Literatur im Kulturvergleich“.

Auf der Basis der erstellten Moodle-Zielkurse führten die ausgebildeten Tutor/inn/en eigenständig Veranstaltungen zur Vermittlung von Informationskompetenz mit insgesamt 49 Studierenden durch.

Zur Evaluation des Konzepts wurden mehrere Methoden eingesetzt, die im Folgenden zusammen mit den Ergebnissen vorgestellt werden.

4. Kompetenzorientiertes Assessment

Ein wesentliches Anliegen des Projekts war es, den Nutzen des Vermittlungskonzepts TUBLIK mit einem kompetenzorientierten Verfahren nachzuweisen. Es sollte damit die Grundlage für eine sozialwissenschaftliche Fundierung der Evaluation geschaffen werden. Mit der am ZPID im Rahmen des Projekts BLink11 entwickelten Assessment-Methode stand ein Instrument zur Verfügung, das in dem zur Verfügung stehenden sehr engen Zeitrahmen an die Anforderungen von TUBLIK angepasst werden konnte.12

Auf Grund der Orientierung des TUBLIK-Projekts an den Standards der Informationskompetenz13 und den Empfehlungen der HRK wurden zusätzliche Situationen mit entsprechenden Handlungsalternativen in das kompetenzorientierte Assessment aufgenommen, die sich auf Themenerarbeitung, Social Media, Rechtsfragen, Informations-/Literaturmanagement, Urheberrecht, Ermittlung und Erarbeitung von neuen Datenbanken beziehen. Das primär auf Recherchekompetenzen beschränkte Assessmentinstrument des ZPID14 musste dementsprechend an die umfassenderen Inhalte des TUBLIK-Projekts angepasst werden.

In dem eingesetzten Fragebogen werden die Studierenden mit konkreten Situationen bzw. Problemen und möglichen Handlungsalternativen konfrontiert. Sie sollen die Eignung der aufgelisteten Handlungsalternativen für die Lösung des Problems auf einer fünfstufigen Skala von 1 für „sehr gut geeignet“ bis 5 für „überhaupt nicht geeignet“ beurteilen. Die Fragebogen waren jeweils im ersten und im letzten Termin der Veranstaltung auszufüllen. Durch ein Kodierungsverfahren wurden die Anonymisierung und individuelle Zuordnung der Kompetenzwerte gewährleistet.

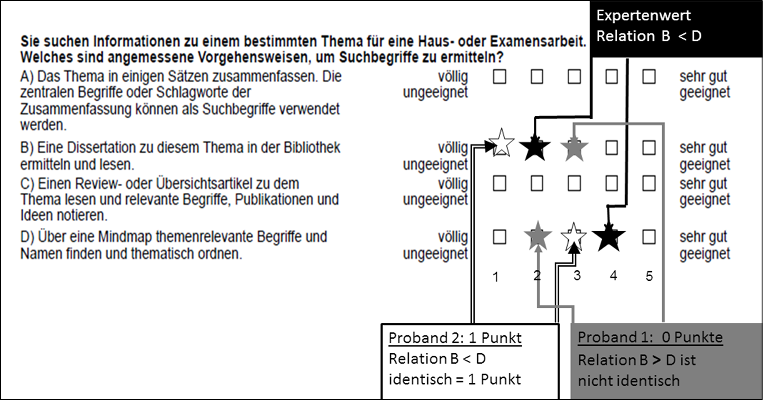

Die Grundlage für die Kompetenzmessung bilden Präferenzrelationen und ein expertenbasierter Auswertungsschlüssel. Die Präferenzrelationen basieren auf den angebotenen Handlungsalternativen. Das bedeutet, dass die Teilnehmenden bzw. Proband/inn/en beurteilen, ob beispielsweise Alternative B zur Problemlösung geeigneter ist als Alternative D. Der expertenbasierte Auswertungsschlüssel basiert ebenfalls auf Präferenzrelationen, die durch eine Befragung von Expert/-

inn/en mit Informationskompetenz statistisch ermittelt wurden15. Wie in der folgenden Abbildung veranschaulicht, ist die Vergabe eines Punktes bei der Kompetenzmessung davon abhängig, ob die Bewertungsrelation zwischen den Handlungsalternativen mit denen der Expert/inn/en übereinstimmt, unabhängig von den absoluten Werten.

Bei der Kompetenzmessung erhält z.B. der Proband 2 einen Punkt, weil er die Handlungsalternative B) mit „1“ (völlig ungeeignet) bewertet, während er bei der Handlungsalternative D) den höheren Wert „3“ vergibt. Es besteht damit eine relative Übereinstimmung mit den Expert/inn/en, die bei B) den Wert „2“ und bei D) den höheren Wert „4“ vergeben haben. Der Proband 2 und die Expert/-inn/en beurteilen also die Handlungsvariante D) in gleicher Weise höher als Handlungsvariante B), auch wenn die absoluten Werte nicht identisch sind. Demgegenüber erhält der Proband 1 keinen Punkt, weil er die Handlungsalternative B) höher bewertet als Variante D).

Auf der Grundlage des Auswertungsschlüssels wurde die Informationskompetenz bei den Teilnehmenden der drei Tutorien gemessen16 und es konnte ein signifikanter Kompetenzzuwachs nachgewiesen werden. Dabei wurde die durchschnittliche Punktzahl der ersten Messung zu Semesterbeginn mit dem Ergebnis der zweiten Messung am Semesterende mittels eines t-Tests für verbundene Stichproben verglichen. Die ermittelte Steigerung von 2,6 ist dabei mit einem p-Wert von 0,01 signifikant.17

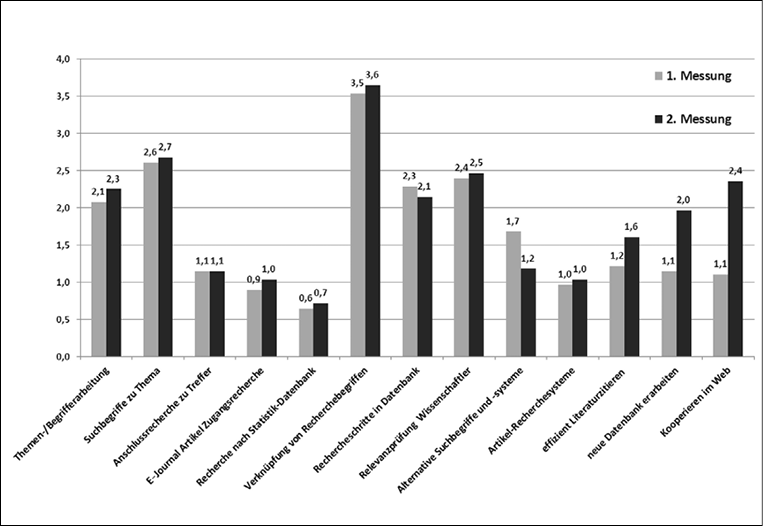

Die ermittelten Daten ermöglichten auch eine differenzierte Analyse nach Kompetenzbereichen, denen die Handlungssituationen mit ihren entsprechenden Handlungsalternativen zugeordnet werden konnten. Die dabei festgestellten Unterschiede sind aus folgender Abbildung zu ersehen.

Mit Ausnahme von zwei Kompetenzbereichen (Rechercheschritte in Datenbanken, alternative Suchbegriffe und -systeme) konnte eine Steigerung erzielt werden. Besonders ausgeprägt war der Kompetenzzuwachs in den Bereichen „neue Datenbank erarbeiten“ (+0,9) und „Kooperieren im Web“ (+1,3).18

Aus den Detailanalysen und den Ergebnissen der weiteren in TUBLIK eingesetzten Evaluationsmethoden ergaben sich wichtige Hinweise für die Weiterentwicklung des Konzepts.19

5. Outcome-basierte Evaluation

Kompetenz zeigt sich bei der konkreten Bewältigung von realen Problemen z.B. mit der Arbeit an einem Vortrag oder einer Hausarbeit, die als Outcome zu sehen sind. Bezogen auf Informationskompetenz, zählt hierzu insbesondere die Ermittlung von Literatur zu einem Thema und zur Erstellung einer Literaturliste. Es ist eine grundlegende Fähigkeit, die für die Erstellung von wissenschaftlichen Arbeiten erforderlich ist und die den inhaltlichen Schwerpunkt des TUBLIK Konzepts bildet. Es wird deshalb erwartet, dass die Teilnehmenden entsprechende Anforderungen effizienter bewältigen als Studierende, die nicht an einer solchen Veranstaltung teilgenommen haben.

Um dies zu überprüfen, wurde ein Vergleich zwischen den drei TUBLIK-Veranstaltungen und zwei anderen Veranstaltungen durchgeführt, deren Teilnehmende als Kontrollgruppe fungierten.20 Konkret sollten die Teilnehmende der TUBLIK-Veranstaltungen und der Kontrollgruppe Literatur zu einem vorgegebenen Thema ermitteln und eine Literaturliste in einem ebenfalls vorgegebenen fachrelevanten Zitierstil erstellen. Die Proband/inn/en hatten hierfür 30 Minuten Zeit. Insgesamt konnten 46 Punkte auf Basis der folgenden Beurteilungskriterien erreicht werden: Anzahl und Art der Literatur, Zitierweise und Literatursortierung.

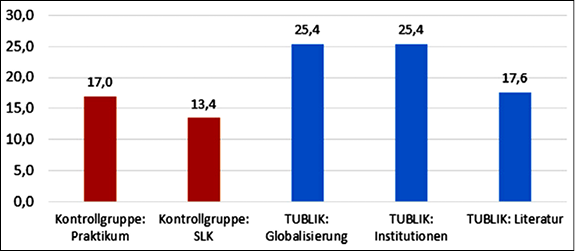

Wie aus der folgenden Abbildung zu ersehen ist, wurden in den TUBLIK-Veranstaltungen durchgehend höhere Werte als in den Kontrollgruppen erzielt.

In den TUBLIK Veranstaltungen „Globalisierung“ und „Institutionen“ wurden Mittelwerte von 25,4 Punkten erzielt. Bei der Veranstaltung „TUBLIK-Literatur“ lag der Wert mit 17,6 Punkten niedriger, was auf den hohen Anteil nicht deutschsprachiger Studierender zurückzuführen ist. In den beiden als Kontrollgruppen fungierenden Veranstaltungen „Praktikum“ und „SLK“ wurden Mittelwerte von 17,0 und 13,4 Punkten erzielt. Auch bei dieser Evaluationsmethode konnte damit der Nutzen von TUBLIK für die Vermittlung von Informationskompetenz erfolgreich nachgewiesen werden.

6. Konzeptbezogene Evaluation

Von grundlegender Bedeutung für die Weiterentwicklung des TUBLIK-Konzepts war die Berücksichtigung der Meinungen der Tutor/inn/en, die als Multiplikatoren die Veranstaltungen leiteten, und der Studierenden, die an den Veranstaltungen teilnahmen. Hierzu wurden am Ende der Veranstaltungen Befragungen mit geschlossenen und offenen Fragen durchgeführt.

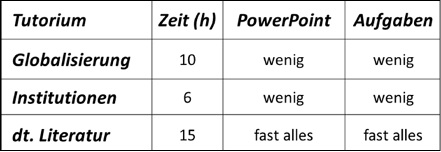

Erfreulich war, dass die Tutor/inn/en21 auf fünf-stufig skalierten Antwortvorgaben das TUBLIK-Konzept als „sehr gut“ (1) oder „gut geeignet“ (2) beurteilten, mit der Durchführung der Veranstaltungen „sehr zufrieden“ (1) oder „zufrieden“ (2) waren und den Lernzuwachs der Teilnehmenden durchgängig als „hoch“ (2) einschätzten. Wie die folgende Tabelle zeigt, bestätigte die Befragung auch den mit TUBLIK angestrebten Rationalisierungseffekt bei der Erstellung der Zielkurse.

Die Tutor/inn/en benötigten zwischen 12 und 30 Stunden für die Erstellung der Zielkurse. Für die Übernahme und Anpassung der Tutorien „Globalisierung“ und „Institutionen“ wurden nur 12 bzw. 20 Stunden benötigt, da schon der Musterkurs exemplarisch auf bildungswissenschaftliche Inhalte ausgerichtet war. Im Tutorium zur „deutschen Literatur“ war der Anpassungsaufwand höher, da die Lehr-/Lernelemente an das andere Fach zu adaptieren waren. Alle Tutor/inn/en beurteilten die Teilnahmeanforderungen, das Erstellen eines Arbeitspapiers und einer EndNote-Literaturdatenbank, als „sehr wichtige“ oder „wichtige“ Elemente des TUBLIK-Konzepts.

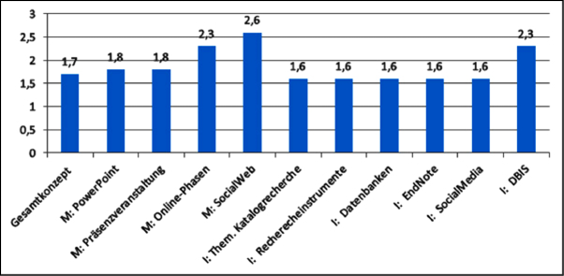

Die Studierenden, die an den TUBLIK-Veranstaltungen teilnahmen, wurden im Rahmen des zweiten kompetenzorientierten Assessments nach ihrer Meinung zum Gesamtkonzept, zu den Inhalten (I) und den angewendeten Methoden (M) befragt, zur Beantwortung standen wiederum fünf Bewertungskategorien von „sehr nützlich“ (1) bis „absolut unnütz“ (5) zur Auswahl. Erfreulich war auch hier, dass das Gesamtkonzept mit einem Mittelwert von 1,7 insgesamt positiv bewertet wurde, wie aus der folgenden Tabelle zu ersehen ist.

Im Hinblick auf die Methoden wurden die verwendeten PowerPoint-Präsentationen und die Präsenzveranstaltungen ebenfalls als „sehr nützlich“ oder „nützlich“ erachtet und erzielten eine Mittelwert von 1,8. Weniger gut fiel die Beurteilung der Methoden „Online-Phase“ und „Social Web“ mit Werten von 2,3 und 2,6 aus. Hier wirkte sich die geringe Erfahrung mit diesen Methoden sowohl auf Seiten der Tutor/inn/en als auch der Studierenden aus. Bei der Überarbeitung wurden entsprechende didaktisch-methodischer Änderungen vorgenommen.22

Bei den Inhalten sind die Mittelwerte von 1,6 bei der thematischen Katalogrecherche, den Datenbanken, EndNote und Social Media sehr positiv zu sehen. Der relativ schlechte Wert von DBIS, als Rechercheinstrument zur Ermittlung von geeigneten Datenbanken, resultierte aus Mängeln bei der didaktisch-methodischen Aufbereitung, die bei der Überarbeitung behoben werden konnten.23

7. Folgerungen und Perspektiven

Mit den im TUBLIK-Projekt eingesetzten Evaluationsinstrumenten konnte der Nutzen des Schulungskonzepts TUBLIK erfolgreich nachgewiesen werden. Dies hat sich als sehr nützlich bei Gesprächen zur Integration von TUBLIK in die Curricula der jeweiligen Studienfächer erwiesen. Besonders die ebenfalls aufgezeigte Möglichkeit zur rationellen und flexiblen Nachnutzung des modularen Angebots für eigene Veranstaltungen hat die Bereitschaft zur Übernahme des Konzepts und die Akzeptanz von Informationskompetenz als Teil der wissenschaftlichen Arbeitstechniken erhöht.

Als großer Vorteil für die Evaluation erwies sich die Kooperation mit dem ZPID. Die dort entwickelten kompetenzorientierten Methoden konnten mit einem relativ geringen Aufwand24 für die Entwicklung eines umfassenderen Assessmentinstruments im TUBLIK-Projekt genutzt werden. Anzustreben ist allerdings eine systematische Weiterentwicklung, um die Validität und Reliabilität dieser Methoden in anderen Kontexten zu verbessern. Wissenschaftliche Einrichtungen, wie das ZPID, sollten hierbei systematisch als Kooperationspartner einbezogen werden. Insbesondere bei der Erstellung von expertenbasierten Auswertungsschlüsseln ist noch viel Entwicklungsarbeit zu leisten, um einen universellen oder fachbezogenen Einsatz zu ermöglichen und gleichzeitig wissenschaftlichen Standards gerecht zu werden. Von Seiten der Bibliotheken müssen allerdings auch entsprechende methodische Kompetenzen aufgebaut werden, um eine sachgerechte Nutzung der Evaluationsinstrumente zu gewährleisten und damit in diesem Bereich Anschluss an die internationale Entwicklung im Bibliotheks- und Informationswesen zu finden.

Literaturverzeichnis

– Association of College and Research Libraries: Information literacy competency standards for higher education, Chicago: ACRL, 2000. http://www.ala.org/acrl/files/standards/standards.pdf (05.10.2015).

– Balceris, Michael: Medien- und Informationskompetenz: Modellierung und Messung von Informationskompetenz bei Schülern, Paderborn: Universität 2011. http://nbn-resolving.de/urn:nbn:de:hbz:466:2-8199.

– Bortz, Jürgen; Schuster, Christof: Statistik für Human- und Sozialwissenschaftler, 7. Aufl., Berlin, Heidelberg: Springer Berlin Heidelberg, 2010. http://dx.doi.org/10.1007/978-3-642-12770-0.

– Deutscher Bibliotheksverband - Dienstleistungskommission: Standards der Informationskompetenz für Studierende, Berlin: Deutscher Bibiotheksverband, 2009. http://www.bibliotheksverband.de/fileadmin/user_upload/Kommissionen/Kom_Dienstleistung/Publikationen/Standards_Infokompetenz_03.07.2009_endg.pdf (05.09.2015).

– Gemeinsame Kommission für Informationskompetenz von VdB und dbv: Best-Practice-Wettwerb 2015. Der Einsatz von E-Learning bei der Vermittlung von Informationskompetenz, Berlin: Deutscher Bibliotheksverband, 2015. http://www.bibliotheksverband.de/fachgruppen/kommissionen/informationskompetenz/best-practice-wettbewerb/2015.html (05.09.2015).

– Hochschulrektorenkonferenz: Hochschule im digitalen Zeitalter: Informationskompetenz neu begreifen - Prozesse anders steuern (Entschließung der 13. Mitgliederversammlung der HRK am 20. November 2012 in Göttingen), Bonn: HRK, 2012. http://www.hrk.de/uploads/media/Entschliessung_Informationskompetenz_20112012.pdf (30.09.2015).

– Homann, Benno: Standards der Informationskompetenz - Eine Übersetzung der amerikanischen Standards der ACRL als argumentative Hilfe zur Realisierung der „Teaching Library“. In: Bibliotheksdienst 36 (2002), H. 5, S. 625- 637. http://nbn-resolving.de/urn:nbn:de:kobv:109-1-5192046.

– Kirk, Thomas: A comparison of two methods of library instruction for students in introductory biology. In: College & research libraries 32 (1971), H. 6, S. 465–474. http://dx.doi.org/10.5860/crl_32_06_465.

– Kuckartz, Udo u.a.: Statistik : Eine verständliche Einführung, 2. Aufl., Wiesbaden: VS Verlag für Sozialwissenschaften, 2013. http://dx.doi.org/10.1007/978-3-531-19890-3.

– Mayer, Anne-Kathrin (Hg.): Informationskompetenz im Hochschulkontext: interdisziplinäre Forschungsperspektiven, Lengerich: Pabst Science Publ., 2015.

– Mayer, Anne-Kathrin u.a.: Mit „BLInk“ zu fachlicher Informationskompetenz - Ein Blended Learning-Kurs für die wissenschaftliche Psychologie und verwandte Fächer. In: Information - Wissenschaft und Praxis. 66 (2015), H. 4, S. 237–241. http://dx.doi.org/10.1515/iwp-2015-0041.

– Mery, Yvonne; Newby, Jill; Peng, Ke: Performance-based assessment in an online course: comparing different types of information literacy instruction. In: portal: libraries and the academy 12 (2012), H. 3, S. 283–298. http://dx.doi.org/10.1353/pla.2012.0029.

– Rosman, Tom; Mayer, Anne-Kathrin; Krampen, Günter: Measuring psychology students’ information-seeking skills in a situational judgment test format. Construction and validation of the PIKE-P test. In: European journal of psychological assessment 31 (2015), H. 2, S. 1–10. http://dx.doi.org/10.1027/1015-5759/a000239.

– Scharf, Davida: An intervention and assessment to improve information literacy. New Brunswick: Rutgers University (ProQuest, UMI Dissertations Publishing), 2013. http://dx.doi.org/doi:10.7282/T3QF8RGH.

– Swain, Matthew; Sundre, Donna L.; Clarke, Kathy: Information Literacy Test (ILT) - Test Manual, Harrisonburg: Madison Assessment, 2014. http://www.madisonassessment.com/uploads/ILT%20Test%20Manual%20May%202014%20pdf_3.pdf (17.09.2015).

– Walsh, Andrew: Information literacy assessment: Where do we start? In: Journal of Librarianship and Information Science 41 (2009), H. 1, S. 19–28. http://dx.doi.org/10.1177/0961000608099896.

– Wolstenholme, Jackie: Evidence based practice using formative assessment in library research support. In: Evidence based library and information practice 10 (2015), H. 3, S. 4–29. http://ejournals.library.ualberta.ca/index.php/EBLIP/article/view/24066/18797 (11.10.2015).

1 Vgl. Gemeinsame Kommission für Informationskompetenz von VdB und dbv: Best-Practice-Wettwerb 2015. Der Einsatz von E-Learning bei der Vermittlung von Informationskompetenz, Berlin: Deutscher Bibliotheksverband, 2015. http://www.bibliotheksverband.de/fachgruppen/kommissionen/informationskompetenz/best-practice-wettbewerb/2015.html (01.10.2015).

2 Vgl. Hochschulrektorenkonferenz: Hochschule im digitalen Zeitalter: Informationskompetenz neu begreifen - Prozesse anders steuern (Entschließung der 13. Mitgliederversammlung der HRK am 20. November 2012 in Göttingen), Bonn: HRK, 2012. http://www.hrk.de/uploads/media/Entschliessung_Informationskompetenz_20112012.pdf (30.09.2015).

3 Vgl. Kirk, Thomas: A comparison of two methods of library instruction for students in introductory biology. In: College & research libraries 32 (1971) H. 6, S. 465–474. http://dx.doi.org/10.5860/crl_32_06_465.

4 Einen guten Einblick in die in den letzten Jahren genutzten Methoden gibt Andrew Walsh in einer Analyse von 91 Publikationen zur Informationskompetenz. Walsh, Andrew: Information literacy assessment: Where do we start? In: Journal of librarianship and information science 41 (2009), H. 1, S. 19–28. http://dx.doi.org/10.1177/0961000608099896. – Einen historischen Überblick über die Entwicklung und Nutzung von Evaluationsmethoden einschließlich der Nutzung von Computern bei Essayanalysen enthält auch die Dissertation von Scharf, Davida: An intervention and assessment to improve information literacy, New Brunswick: Rutgers University (ProQuest, UMI Dissertations Publishing), 2013. http://dx.doi.org/doi:10.7282/T3QF8RGH.

5 Der Test basiert auf deklarativen Wissensabfragen, wie aus dem Testmanual zu ersehen ist: Swain, Matthew; Sundre, Donna L.; Clarke, Kathy: Information Literacy Test (ILT) - Test Manual, Harrisonburg: Madison Assessment, 2014. http://www.madisonassessment.com/uploads/ILT%20Test%20Manual%20May%202014%20pdf_3.pdf (17.09.2015).

6 Association of College and Research Libraries: Information literacy competency standards for higher education, Chicago: ACRL, 2000. http://www.ala.org/acrl/files/standards/standards.pdf (05.10.2015).

7 Vgl. Balceris, Michael: Medien- und Informationskompetenz: Modellierung und Messung von Informationskompetenz bei Schülern, Paderborn: Universität, 2011. http://nbn-resolving.de/urn:nbn:de:hbz:466:2-8199.

8 Einen guten Überblick über den Stand der Vermittlungskonzepte und die Forschung im Bereich der Informationskompetenz in Deutschland geben die auf einem Symposium des ZPID basierenden Beiträge in der Aufsatzsammlung von Mayer, Anne-Kathrin (Hg.): Informationskompetenz im Hochschulkontext: interdisziplinäre Forschungsperspektiven, Lengerich: Pabst Science Publ., 2015.

9 Siehe hierzu Mayer, Anne-Kathrin u.a.: Mit „BLInk“ zu fachlicher Informationskompetenz - Ein Blended Learning-Kurs für die wissenschaftliche Psychologie und verwandte Fächer. In: Information - Wissenschaft und Praxis 66 (2015), H. 4, S. 237–241. http://dx.doi.org/10.1515/iwp-2015-0041.

10 Rosman, Tom; Mayer, Anne-Kathrin; Krampen, Günter: Measuring psychology students’ information-seeking skills in a situational judgment test format. Construction and validation of the PIKE-P test. In: European journal of psychological assessment 31 (2015), H. 2, S. 1–10. http://dx.doi.org/10.1027/1015-5759/a000239. - Der Bezug auf eine konkrete Situation und dabei mögliche Handlungsalternativen ist das Merkmal von Testverfahren, die insbesondere in der Kompetenzforschung genutzt und dort als „Situational Judgement Test“ bezeichnet werden.

11 Vgl. Mayer, Anne-Kathrin u.a.: Mit „BLInk“ zu fachlicher Informationskompetenz, (wie Anm. 9).

12 Die Projektmittel in Höhe von ca. 50.000 EUR standen nur für den Zeitraum von knapp einem Jahr für die Entwicklung des Schulungskonzepts und die Anpassung von Evaluationsinstrumenten zur Verfügung. Die Unterstützung durch das ZPID war daher für die Evaluation von TUBLIK von grundlegender Bedeutung.

13 Siehe: Deutscher Bibliotheksverband - Dienstleistungskommission: Standards der Informationskompetenz für Studierende, Berlin: Deutscher Bibliotheksverband, 2009. http://www.bibliotheksverband.de/fileadmin/user_upload/Kommissionen/Kom_Dienstleistung/Publikationen/Standards_Infokompetenz_03.07.2009_endg.pdf (05.09.2015). Eine wichtige Grundlage für die Entwicklung dieser Standards bildet die Übersetzung der amerikanischen Standards, die ergänzende Ausführungen enthalten. Siehe hierzu Homann, Benno: Standards der Informationskompetenz - Eine Übersetzung der amerikanischen Standards der ACRL als argumentative Hilfe zur Realisierung der „Teaching Library“. In: Bibliotheksdienst 36 (2002), H. 5, S. 625–637. http://nbn-resolving.de/urn:nbn:de:kobv:109-1-5192046.

14 Das „BLink“-Konzept umfasst drei Module mit einer auf ca. 10 Stunden geschätzten Lernzeit. Das TUBLIK-Vermittlungskonzept ist als curriculare Wahlpflichtveranstaltung mit einem Workload von ca. 60 Stunden konzipiert.

15 Für die Erstellung des Auswertungsschlüssels bearbeiteten 21 Informationsexpert/inn/en den Fragenbogen. Auf Grund ihrer Hochschulausbildung und ihrer beruflichen Tätigkeit in wissenschaftlichen und bibliothekarischen Bereichen wurde davon ausgegangen, dass sie über das entsprechende Expert/inn/enwissen verfügen. Bei der Festlegung des Auswertungsschlüssels wurden nur Präferenzrelationen aufgenommen, wenn mindestens 70 Prozent der Expert/inn/-en bei der jeweiligen Präferenzrelation übereinstimmten. Handlungsalternativen, die dieses Kriterium nicht erfüllten, wurden ausgeschieden. Auch bei den Expert/inn/en erfolgte eine statistische Selektion von „Ausreißern“. Drei von ihnen, die in ihren Präferenzrelationen über alle Items stark von den Präferenzrelationen der übrigen Expert/inn/en abwichen, wurden aus dem Sample der Expert/inn/en herausgenommen. Auf diese Weise wurde eine homogenere Beurteilungsgrundlage geschaffen.

16 An den Tutorien beteiligten sich 49 Studierende. Durch technische und organisatorische Faktoren war der individuelle Kompetenzvergleich nur bei 28 Studierenden möglich.

17 Der P-Wert gibt an, mit welcher Wahrscheinlichkeit die Kompetenzsteigerung von 2,6 rein zufällig ist. Da die Zufallswahrscheinlichkeit mit einem p-Wert von 0,01 unter 1 Prozent liegt, kann von einem signifikanten Effekt des TUBLIK-Vermittlungskonzepts auf die Informationskompetenz der Teilnehmenden ausgegangen werden. Aus der umfangreichen Literatur seien hier genannt: Bortz, Jürgen; Schuster, Christof: Statistik für Human- und Sozialwissenschaftler, 7. Aufl., Berlin, Heidelberg: Springer, 2010. http://dx.doi.org/10.1007/978-3-642-12770-0. - Kuckartz, Udo u.a.: Statistik : Eine verständliche Einführung, 2. Aufl., Wiesbaden: VS Verlag für Sozialwissenschaften, 2013. http://dx.doi.org/10.1007/978-3-531-19890-3.

18 Die statistische Analyse bestätigte hier auch erneut die Signifikanz. Bei der „Datenbankerarbeitung“ wurden als Werte erzielt: (t (27) = -3.0, p = .01, d = 1.14) und bei „Social Web“ (t (27) = -3.6, p = .00, d = 1.40).

19 So konnte herausgearbeitet werden, dass der Kompetenzrückgang bei „Alternative Suchbegriffe“ im Wesentlichen auf die Teilnehmenden in dem Tutorium des „Instituts für Deutsch als Fremdsprache“ zurückzuführen ist (t (6) = 2.5, p = .05, d = 2.04). Ein Großteil der Studierenden dieses Fachbereichs kam aus dem Ausland und hatte teilweise beträchtliche Sprachprobleme. Hier müssen in zukünftigen Kursen kompensatorische Inhalte und Methoden entwickelt werden.

20 Die Validität ist bei dieser Testmethode durch die Realitätsnähe höher als bei der kompetenzbasierten Evaluation. Die Realitätsnähe zeigt sich nicht zuletzt an der Komplexität der Anforderungen, die im Rahmen eines Studiums meist bei Hausarbeiten oder Examensarbeiten zu bewältigen ist. Dem steht als Nachteil gegenüber, dass eine reliable Bewertung schwierig und zeitaufwendig ist. Um die Reliabilität zu erhöhen, wurden bei der Bewertung primär nur formale Kriterien genutzt. Eine systematische Einbeziehung inhaltlicher bzw. fachlicher Beurteilungskriterien ist allerdings anzustreben, wobei Erfahrungen angloamerikanischer Studien genutzt werden können, wie z.B. Scharf, Davida: An intervention and assessment to improve information literacy, (wie Anm. 4); Wolstenholme, Jackie: Evidence based practice using formative assessment in library research support. In: Evidence based library and information practice 10 (2015), H. 3, S. 4–29. http://ejournals.library.ualberta.ca/index.php/EBLIP/article/view/24066/18797 (11.10.2015) sowie auch Mery, Yvonne; Newby, Jill; Peng, Ke: Performance-based assessment in an online course: comparing different types of information literacy instruction. In: portal: libraries and the academy 12 (2012), H. 3, S. 283–298. http://dx.doi.org/10.1353/pla.2012.0029.

21 Insgesamt beteiligten sich sechs der sieben Tutor/inn/en an der Evaluation. Eine Tutorin konnte aus persönlichen Gründen nicht teilnehmen.

22 Negativ wurde der Einsatz von Twitter beim Modul „Bibliothek entdecken“ gewertet, weshalb dieses Social Media Tool bei der methodischen Überarbeitung nicht mehr eingesetzt wurde.

23 Als vorteilhaft erwies sich dabei die Möglichkeit einer differenzierten Analyse zwischen den Veranstaltungen. Aus Unterschieden in der Bewertung, die mit Unterschieden in der Methoden korrespondierten, konnten Vorschläge zur methodischen Verbesserung einzelner Module erarbeitet werden.

24 Die Entwicklung des um situationsbezogene Fragen erweiterten Assessmentverfahrens musste auf Grund des engen zeitlichen Rahmens der Projektdauer innerhalb eines Monats erfolgen.